,![]() Techritual 香港科技电脑资讯网站,,

Techritual 香港科技电脑资讯网站,, Techritual 香港科技电脑资讯网站,,Nvidia 再有更新,直接将 H100 GPU 的 AI 性能提昇最多 8 倍,16/09/2023,

Techritual 香港科技电脑资讯网站,,Nvidia 再有更新,直接将 H100 GPU 的 AI 性能提昇最多 8 倍,16/09/2023, 十斗,1129,

十斗,1129, ,

,

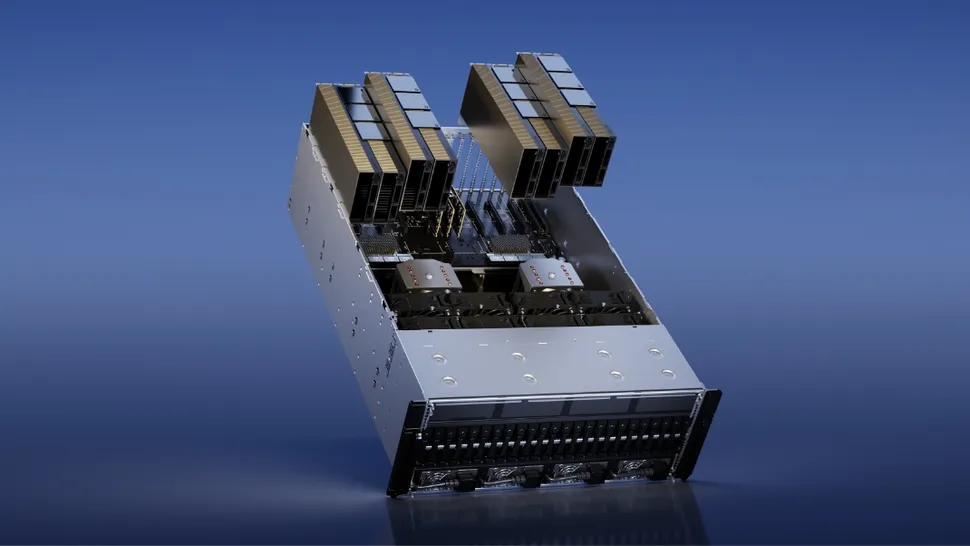

Nvidia 与一系列科技合作夥伴携手合作,开发了一款具有突破性的软体,预计能将旗舰 H100 Tensor Core GPU 的性能提升一倍。这款名为 TensorRT-LLM 的开放源码更新预计在未来几周内发布,该系统的最新版本在性能上超越了 A100,达到了八倍的提升,而之前 H100 只能达到四倍的性能提升。这一测试是在 GPT-J 6B 上进行的,该模型被用於摘要 CNN 和 Daily Mail 的文章。

在 Meta 的 Llama2 LLM 上进行测试时,搭载 TensorRT-LLM 的 H100 GPU 在更新前比 A100 GPU 的性能提升了 4.6 倍,而更新後则提升了 2.6 倍。

Nvidia H100 GPU 的性能再度提升

大型语言模型的多样性和动态性使得批量请求并行执行变得困难,这意味着一些请求的完成时间比其他请求更早。为了解决这个问题,Nvidia 与其合作夥伴将 TensorRT-LLM 嵌入了一种更强大的调度技术,称为 in-flight batching。这种技术利用了文本生成可以分解为多个子任务的特点。

简单来说,系统在处理下一个请求之前,不需要等待一个请求的整个批量任务完成,而是可以同时处理来自不同请求的新批量任务。TensorRT-LLM 包括 TensorRT 深度学习编译器,并且包含了优化的核心、预处理和後处理步骤,以及多 GPU 和多节点通信原语。

结果 Nvidia 的 GPU 在性能上取得了突破性的成果,为新的大型语言模型实验、快速定制和最佳性能铺平了道路。这款软体使用了张量平行处理技术,将个别权重矩阵分散在多个设备上,从而实现了高效的推论;每个模型在多个 GPU 和多个伺服器上并行运行。

TensorRT-LLM 还包括了 Llama 2、GPT-2、GPT-3 以及 Falcon、Mosaic MPT、BLOOM 等数十种热门语言模型的完全优化和可直接运行的版本。这些模型可以通过 Python API 进行访问。该更新版本已提供早期访问,并将很快整合到 Nvidia NeMo 框架中,该框架是 Nvidia AI Enterprise 的一部分。研究人员可以通过 NeMo 框架、NGC 门户或 GitHub 上的源代码库进行访问。

, Techritual 香港River

Techritual 香港River